Dans le monde du référencement, les chiffres ont un pouvoir de séduction énorme. En parcourant une étude SEO, on aime tous apprendre qu’« en moyenne, les pages en haut de Google comptent X mots », ou que « les sites les plus visibles publient Y articles par mois ».

Le risque pour un consultant SEO ? S’empresser de transformer ces constats en règles immuables. Comme si un simple volume de texte suffisait à garantir un meilleur positionnement sur les SERPs. Ce raisonnement confond deux notions fondamentales de la science statistique : la corrélation, qui décrit une simple association ; et la causalité, qui démontre un véritable lien de cause à effet.

Quand l’observation devient prescription SEO

Je parcourais hier une étude de James Brockbank, publiée par Digitaloft et reprise par Abondance. L’auteur analyse 300 pages catégorie classées en position 1 sur Google UK au 13 août 2025, en ne comptant que le texte unique hors grille produits et H1.Les chiffres sont parlants :

- 310 mots en moyenne par page catégorie.

- 66 % des pages comptent moins de 400 mots.

- Près de 44 % des pages contiennent entre 1 et 200 mots.

- Et environ 10 % sans texte hors H1.

À partir de ces données, l’auteur de l’étude avance que la longueur du texte n’est pas un facteur décisif de classement dans Google pour les pages catégories. Selon lui, ce qui compte avant tout est la pertinence du contenu vis-à-vis de l’intention d’achat et sa capacité à accompagner la conversion. Autrement dit, inutile d’ajouter des centaines de mots artificiels : un contenu concis mais pertinent peut suffire, à condition qu’il serve réellement l’utilisateur.

Corrélation, causalité et crème glacée

« Corrélation n’implique pas causalité ». Si vous avez déjà suivi un cours de statistiques, cette phrase vous est sans doute familière. Et pourtant, elle reste l’un des pièges les plus courants dans les raisonnements SEO.

Prenons un exemple classique. Chaque été, les ventes de glaces augmentent… tout comme le nombre d’incendies de forêt. Faut-il en conclure que manger une glace met le feu à la garrigue ? Évidemment non. Ces deux événements sont simplement liés à une troisième variable : la chaleur estivale. C’est elle qui pousse les gens à s’offrir une crème glacée et qui assèche les sols jusqu’à favoriser les départs de feu.

Cette erreur logique a un nom : la confusion entre corrélation et causalité. Deux phénomènes peuvent évoluer ensemble sans qu’il y ait le moindre lien de cause à effet entre eux.

Pour y voir plus clair, quelques définitions essentielles s’imposent :

- Corrélation : une association statistique entre deux variables. Elles évoluent ensemble, sans que l’on sache si l’une influence réellement l’autre.

- Causalité : un lien de cause à effet démontré. Une variable a un impact direct et mesurable sur l’autre.

- Variable confusionnelle : une troisième variable invisible qui influence à la fois la cause supposée et l’effet observé. C’est elle qui crée une illusion de causalité.

Transposée au SEO, c’est exactement cette confusion entre corrélation et causalité que produit l’étude Digitaloft. Elle observe qu’en août 2025, les pages catégories en tête des SERPs étaient souvent courtes. Mais ça ne prouve en rien que c’est parce qu’elles sont courtes qu’elles sont bien classées.

On confond ici le chant du coq avec le lever du soleil. Si j’avais repris les mêmes requêtes que James Brockbank, j’aurais peut-être découvert qu’en 2025, les pages les mieux positionnées contenaient rarement la lettre Z. De là à en faire un élément prescriptif…

Du bon usage des statistiques en SEO

Mesurer une corrélation, c’est relativement simple. Le statisticien anglais Karl Pearson a mis au point une formule encore utilisée aujourd’hui, le fameux coefficient de corrélation r. Il a aussi été l’un des premiers à rappeler une chose essentielle : deux variables peuvent évoluer ensemble sans qu’il y ait le moindre lien entre elles.

Mais pour prouver qu’un facteur cause un effet, il faut un cadre beaucoup plus exigeant. C’est là qu’intervient Ronald Fisher, autre figure majeure de la statistique moderne. Au début du XXe siècle, il développe les principes de l’expérimentation contrôlée et randomisée : on modifie une seule variable, on neutralise les autres, et on observe l’effet produit.

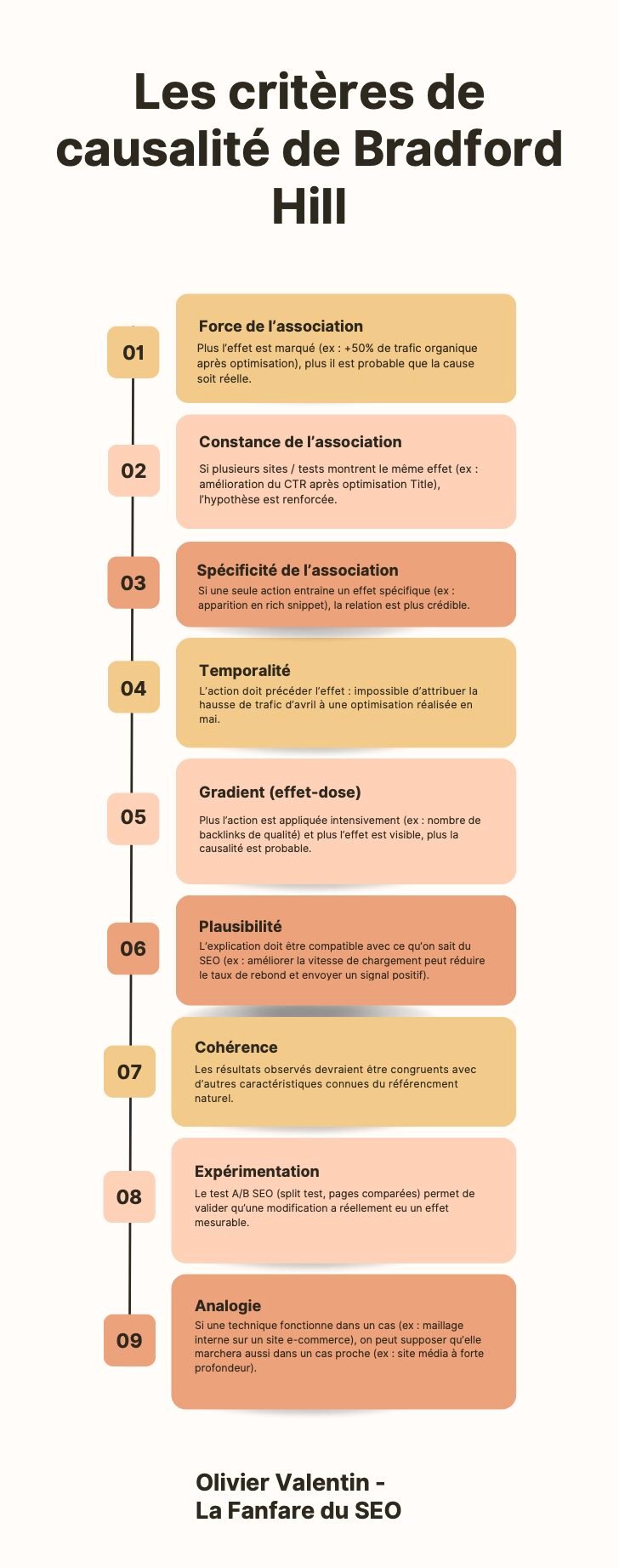

Aujourd’hui, les critères de causalité les plus largement reconnus sont ceux formulés par Bradford Hill. Utilisés à l’origine en épidémiologie, ils permettent d’évaluer si un lien observé entre deux phénomènes est simplement statistique ou réellement causal.

- Force de l’association : plus la corrélation est forte et répétée, plus elle est crédible.

- Cohérence : les résultats se retrouvent dans différents contextes et échantillons.

- Temporalité : la cause précède toujours l’effet.

- Plausibilité : il existe un mécanisme logique qui relie A à B.

- Expérimentation : quand on teste, on retrouve bien l’effet attendu.

Peu d’études SEO vont aussi loin et c’est compréhensible. Tester, isoler, reproduire : tout cela demande des moyens, du temps et un niveau de rigueur difficile à tenir dans un environnement aussi mouvant.

Comment se rapprocher (un peu) de la causalité dans une étude SEO ?

Certaines méthodes permettent tout de même de se rapprocher d’une logique causale, sans avoir besoin de lancer une étude clinique. En voici quelques-unes.

- Analyser un gros volume de données : Plus l’échantillon est large, plus la tendance observée est fiable. On limite les effets du hasard.

- Comparer plusieurs types de site : Un signal valable sur un site e-commerce ne l’est pas forcément sur un site média ou un site local.

- Respecter l’ordre des événements : Une cause vient toujours avant l’effet. Si la page grimpe avant l’optimisation, le lien est rompu.

- Observer sur plusieurs période : Une corrélation isolée peut tromper. Si elle revient dans le temps, elle devient plus crédible.

- Limiter les autres changements : Modifier dix choses à la fois empêche de savoir ce qui a vraiment fait bouger la page.

- Tester à petite échelle : Un split test ou une comparaison entre deux zones d’un site reste ce qu’il y a de plus fiable.

Observer des corrélations, c’est utile. En SEO, on n’a pas toujours mieux. Mais tirer des règles à partir de simples coïncidences, c’est risqué. Une page courte peut bien se positionner sans que ce soit grâce à sa brièveté.

Si l’on veut progresser dans notre compréhension du référencement, il faut apprendre à lire les études pour ce qu’elles sont : des points de départ, pas des modes d’emploi.

À chacun de faire le tri, d’expérimenter, de douter aussi. C’est peut-être là, la seule vraie méthode.

👉 Vous avez déjà testé certaines de ces approches ? Ou repéré des corrélations absurdes qui circulent encore dans le milieu ? Je suis curieux de lire vos retours.